-

Hive集群部署实验

一、实验介绍

1.1 实验内容

在Hadoop集群上部署Hive数据仓库,使用MySQL作为元数据存储。

在Hive集群平台创建测试表,验证HiveQL在Hadoop Mapreduce中的执行情况。1.2 实验知识点

Hive集群工作原理

Hive客户端访问方式

Hive与MySQL的关系1.3 实验环境

Hive2.3.9

VMware Workstation 16 Pro for Windows

虚拟机镜像1.4 实验资源

资源名称 存储目录 Hive安装包 /opt/software/package

1.5 实验步骤清单

hive部署(安装hive、创建元数据库、修改配置文件、创建测试目录、初始化hive)

hive测试(启动hibe、创建测试数据库并验证、使用beeline连接hive)二、实训架构

序号 IP地址 机器名 类型 核数/内存 目录

序号 IP地址 机器名 类型 1 172.25.10.140 master NN/DN/Hive 2 172.25.10.141 slave1 DN/NM 3 172.25.10.142 slave2 DN/NM 4 172.25.10.143 slave3 DN/NM 三、实验环境准备

本次实验需要提前准备好相关服务,需要Hadoop集群、HDFS文件系统、Zookeeper集群控制软件、MySQL数据库的支持。本次实验采用hive-2.3.9版本。

启动虚拟机master、slave1和slave2,slave3输入用户名root密码root登录系统。四、实验步骤

4.1 Hive部署

4.1.1 安装Hive

1、解压和重命名Hive

tar zxvf /opt/software/package/apache-hive-2.3.9-bin.tar.gz -C /usr/local/

mv /usr/local/apache-hive-2.3.9-bin/ /usr/local/hive2、检查环境变量

vim /etc/profileexport HIVE_HOME=/usr/local/hive export PATH=${HIVE_HOME}/bin:${PATH}- 1

- 2

mysql -uroot -p

#创建数据库

create database metastore;

#关闭只读

set global read_only=0;

#设置密码安全策略

set global validate_password_policy=0;

#设置密码长度

set global validate_password_length=4;

#更改密码

ALTER USER 'root'@'localhost' IDENTIFIED BY 'root';

#数据库授权

grant all on metastore.* to hive@'%' identified by 'hive';

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY 'root';#刷新权限

flush privileges;

#退出mysql

exit

#上传mysql-connector到Hive库目录

cp /opt/software/package/mysql-connector-java-5.1.46-bin.jar /usr/local/hive/lib/4.1.3 修改hive配置文件

#复制hive-env.sh

cp /usr/local/hive/conf/hive-env.sh.template /usr/local/hive/conf/hive-env.sh

#修改hive-env.sh文件,参考如下内容:

vim /usr/local/hive/conf/hive-env.shexport JAVA_HOME=//usr/local/jdk/jre export HADOOP_HOME=/usr/local/hadoop export HIVE_HOME=/usr/local/hive export HIVE_CONF_DIR=/usr/local/hive/conf- 1

- 2

- 3

- 4

#复制hive-site.xml

cp /usr/local/hive/conf/hive-default.xml.template /usr/local/hive/conf/hive-site.xml#修改hive-site.xml

替换所有 s y s t e m : j a v a . i o . t m p d i r 为 / u s r / l o c a l / h i v e / t m p 替 换 所 有 {system:java.io.tmpdir} 为/usr/local/hive/tmp 替换所有 system:java.io.tmpdir为/usr/local/hive/tmp替换所有{system:user.name} 为 root

vim /usr/local/hive/conf/hive-site.xml替换所有${system:java.io.tmpdir} 为/usr/local/hive/tmp :1,$s#${system:java.io.tmpdir}#/usr/local/hive/tmp#g #替换当前行的${system:user.name}为root :s/${system:user.name}/root/g #替换所有${system:user.name} 为 root :1,$s/${system:user.name}/root/g- 1

- 2

- 3

- 4

- 5

- 6

注意:逐个替换以下参数内容,其他参数保留原始配置即可。完整配置内容参见“六、参考文档”。

hive.exec.scratchdir /user/hive/tmp hive.metastore.warehouse.dir /user/hive/warehouse hive.querylog.location /user/hive/log javax.jdo.option.ConnectionURL jdbc:mysql://master:3306/metastore?createDatabaseIfNotExist=true&characterEncoding=UTF-8&useSSL=false javax.jdo.option.ConnectionDriverName com.mysql.jdbc.Driver javax.jdo.option.ConnectionUserName root javax.jdo.option.ConnectionPassword root - 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

#创建/usr/local/hive/tmp目录

mkdir /usr/local/hive/tmp

chmod -R 777 /usr/local/hive/tmp#复制log配置文件

cp /usr/local/hive/conf/hive-log4j2.properties.template /usr/local/hive/conf/hive-log4j2.properties

cp /usr/local/hive/conf/hive-exec-log4j2.properties.template /usr/local/hive/conf/hive-exec-log4j2.properties

4.1.4 创建Hadoop测试目录

#启动hadoop

start-all.sh#在hdfs中创建以下目录并授权,用于存储文件

hdfs dfs -mkdir -p /user/hive/warehouse

hdfs dfs -mkdir -p /user/hive/tmp

hdfs dfs -mkdir -p /user/hive/log

````hdfs dfs -chmod -R 777 /user/hive/warehouse

#查看目录

hdfs dfs -ls /user/hive/

4.1.5 初始化hive元数据库

schematool -dbType mysql -initSchema root root

4.2 Hive测试

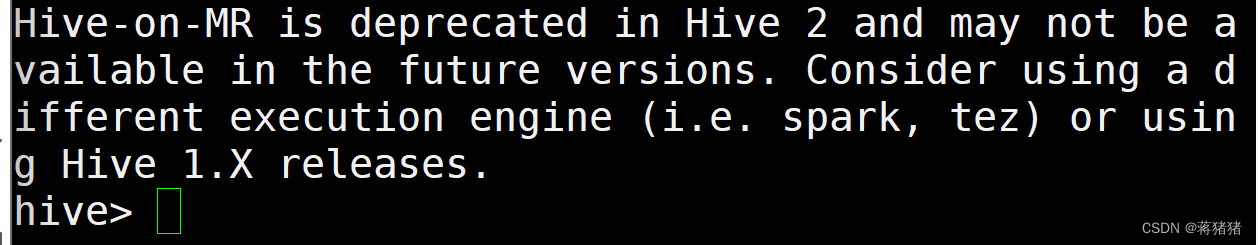

4.2.1 启动Hive

启动mysql

systemctl start mysqld.service

hive

4.2.2 创建测试数据库并验证

#创建数据库

create database testdb;

#查看数据库

show databases;

#使用数据库

use testdb;

exit;五、实验总结

本次实验中,Hive采用MySQL数据库保存Hive的元数据,而不是采用Hive自带的derby来存储元数据。

Hive常用的HiveQL操作命令主要包括:数据定义、数据操作。

Hive实现最大的优势是,对于非程序员,不用学习编写Java MapReduce代码,也可以完成MapReduce任务。 -

相关阅读:

用 SQL 查询每个用户最大连续登录日期

发表博客的模板

Python学习笔记1:reverse()函数和reversed()函数

sklearn机器学习——day10

用C++标准库生成制定范围内的整数随机数

JVM Heap Memory

【maven下载、安装、配置教程】

记录pytorch安装 windows10 64位--第1部分:cuda和cuddn

java计算机毕业设计综合测评系统源码+数据库+系统+部署+lw文档

PGL图学习之图神经网络GraphSAGE、GIN图采样算法[系列七]

- 原文地址:https://blog.csdn.net/qq_49096000/article/details/127907972