-

随机森林算法介绍

随机森林(Random Forest)是一种集成学习方法,主要用于分类和回归任务。它通过集成多棵决策树来提高模型的准确性和泛化能力。以下是随机森林的详细算法介绍:基本原理

随机森林由多棵独立的决策树组成,每棵决策树在训练时从总体数据集中随机抽取一部分数据并使用部分特征进行训练。最终的输出结果是通过这些树的集成(多数投票或平均)来决定的。

关键步骤

-

数据采样(Bootstrap Sampling):

- 从原始训练集中随机有放回地抽取样本,生成多个不同的子集,每个子集用于训练一棵决策树。

-

特征选择(Feature Selection):

- 在构建每棵决策树时,对每个节点分裂时随机选择一部分特征进行评估,而不是使用所有特征。这样增加了模型的多样性,减少了过拟合。

-

决策树构建(Tree Construction):

- 对每个子集,使用选择的特征构建一棵决策树。决策树可以完全生长(不进行剪枝),直到每个叶节点包含少量样本或无法继续分裂。

-

集成预测(Ensemble Prediction):

- 对于分类任务,随机森林通过所有树的多数投票来决定最终分类结果。

- 对于回归任务,随机森林通过所有树的预测结果取平均值来得到最终预测结果。

举例说明

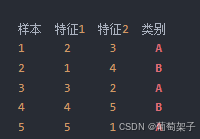

假设我们有一个简单的数据集用于分类,只有两个特征:

数据采样:

生成多个子集,每个子集通过随机有放回地抽取原始数据集的样本。

例如,第一棵决策树的子集可能是:

特征选择:

在每个节点分裂时,随机选择一部分特征进行评估。

例如,根节点可能随机选择特征1和特征2中的一个来进行分裂。

决策树构建:根据选择的特征和分裂点,构建决策树。

例如,根节点选择特征1,分裂点设为3:

特征1 <= 3: 左子节点

特征1 > 3: 右子节点

集成预测:

将新的样本输入所有决策树,收集每棵树的预测结果,通过多数投票或平均值决定最终结果。算法流程

假设有一个数据集 D 由N 个样本和 M 个特征组成,随机森林的构建和预测流程如下:

-

训练阶段:

- 选择决策树数量 n.

- 对于每棵决策树 i,重复以下步骤:

- 从数据集 D 中随机有放回地抽取 N 个样本,生成子集 Di.

- 在每个节点分裂时,从 M 个特征中随机选择 m 个特征(通常 m = M \sqrt{M} M,或log2M ),然后选择最优特征进行分裂。

- 完全生长(构建)决策树,直到达到停止条件(如每个叶节点包含的样本数小于某个阈值或无法继续分裂)。

-

预测阶段:

- 对于分类任务:

- 将测试样本输入每棵决策树,收集所有决策树的分类结果。

- 最终分类结果通过多数投票决定。

- 对于回归任务:

- 将测试样本输入每棵决策树,收集所有决策树的预测值。

- 最终预测结果通过所有预测值的平均值决定。

- 对于分类任务:

优点

- 高准确性:通过集成多棵决策树,随机森林通常能够获得更高的准确性和鲁棒性。

- 抗过拟合:由于每棵决策树在训练时使用随机样本和随机特征,模型能够有效减少过拟合。

- 处理高维数据:能够处理含有大量特征的数据集,并且在特征选择上具有较强的能力。

- 并行化:每棵决策树可以独立构建,因此随机森林天然适合并行计算,提高了训练效率。

缺点

- 计算资源需求大:由于需要构建多棵决策树,随机森林在训练和预测时可能需要较多的计算资源。

- 模型复杂度高:由于集成了大量决策树,随机森林模型较为复杂,难以解释。

- 训练时间长:随着数据量和树的数量增加,训练时间也会显著增加。

实现示例

以下是使用Python的Scikit-Learn库实现随机森林分类器的简要示例:

from sklearn.ensemble import RandomForestClassifier from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.metrics import accuracy_score # 加载数据 data = load_iris() X = data.data y = data.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建随机森林分类器 clf = RandomForestClassifier(n_estimators=100, random_state=42) # 训练模型 clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 评估准确性 accuracy = accuracy_score(y_test, y_pred) print(f'Accuracy: {accuracy:.4f}')总结

随机森林是一种强大的集成学习方法,通过集成多棵决策树来提高预测准确性和泛化能力。它特别适合处理复杂、高维和非线性的数据问题,但需要注意其计算资源需求和训练时间。

-

-

相关阅读:

Java线程安全问题

numpy对行操作总结

靶向用药mPEG-DSPE 甲氧基-聚乙二醇-磷脂酰乙醇胺 CAS:178744-28-0

207. 课程表

基于Vue3+TS的Monorepo前端项目架构设计与实现

【Java】自定义协议

Stream流

扫描线及其应用

ARM编程模型-内存空间和数据

Python-自动化绘制股票价格通道线

- 原文地址:https://blog.csdn.net/wanganqiqi/article/details/142303015